官网在

Using a Private Docker Registry

其实很简单,私仓信息会存在本地的~/.docker目录。把这个目录打成tar.gz的包,然后在marathon配置的时候指定一下就可以了。详见:

1 Tar/Gzip credentials

|

|

|

|

|

|

2.Mesos/Marathon config

增加一个到认证信息的uris就可以了:

|

|

|

|

urls在图形界面里面有,当然你也可以手动编辑json文件,有语法错误他会提示你.

官网在

Using a Private Docker Registry

其实很简单,私仓信息会存在本地的~/.docker目录。把这个目录打成tar.gz的包,然后在marathon配置的时候指定一下就可以了。详见:

|

|

|

|

|

|

增加一个到认证信息的uris就可以了:

|

|

|

|

urls在图形界面里面有,当然你也可以手动编辑json文件,有语法错误他会提示你.

整个过程可以直接看官网

http://mesos.apache.org/gettingstarted/

http://mesos.apache.org/downloads/

Ubuntu 14.04

这里用的openjdk7.

|

|

|

|

完了以后最好运行下check

|

|

|

|

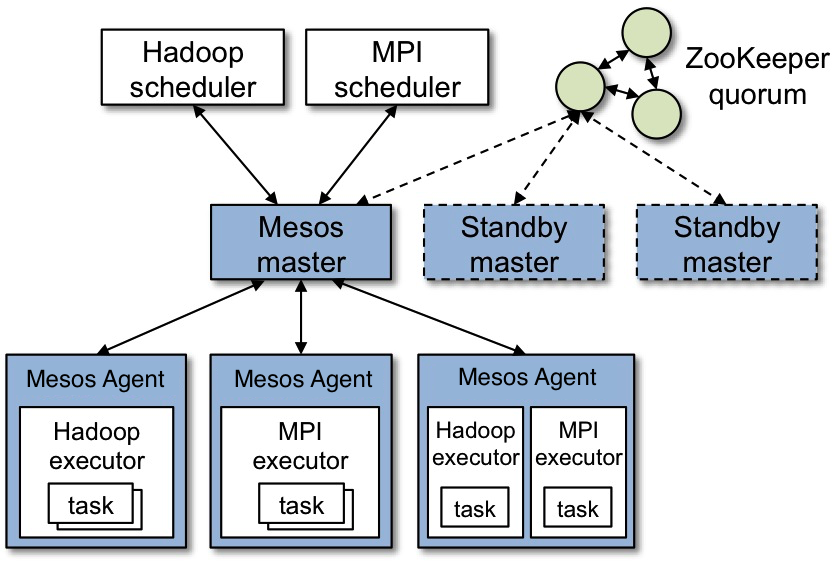

master下面挂了几个agent,会给master上报资源信息.

framework包含了两个概念:

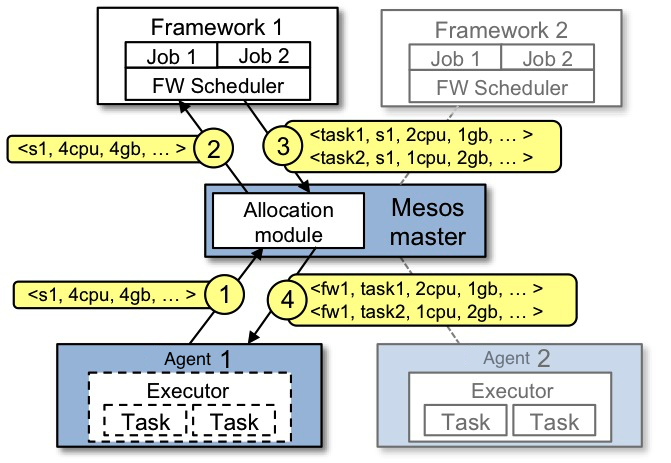

关于framework具体怎样运行还有下面的图来表达这个过程:

可以到官网直接下载二进制包: https://golang.org/dl/

https://storage.googleapis.com/golang/go1.6.3.linux-amd64.tar.gz

设置环境变量:

|

|

这里用编译的方式:

|

|

|

|

会起两个端口,2379,2380.

bin/etcdctl set mykey ‘123’

bin/etcdctl get mykey

看文档https://coreos.com/etcd/docs/latest/

A distributed, reliable key-value store for the most critical data of a distributed system.

其实就是一个高效的kv store,可以做分布式部署。可以做成集群。

这东西非常强大..配置语法跟之前tengine的类似.

主要是使用check关键字:

|

|

关于haproxy其实还是不太理解,可以从简单的着手。

可以写成这样,一个frontend+一个backend:

|

|

也可以写成单独的listen:

|

|

这里还缺了一个很关键的日志记录,日志需要和syslog软件相结合。

需要配置一下rsyslog:

|

|

然后在代码中配置相关内容即可:

|

|

|

|

haproxy提供一个很方便的monitor界面,比nginx_status好看多了.内容也丰富很多.很直观.

|

|

这里不用nginx,原因是nginx自带的健康检查,是以正常请求来试的,这会导致很多问题.这里不详细说.

tengine的非常简单.加个check语句就行了.

http://tengine.taobao.org/document_cn/http_upstream_check_cn.html

该指令可以打开后端服务器的健康检查功能。

指令后面的参数意义是:

interval:向后端发送的健康检查包的间隔。

fall(fall_count): 如果连续失败次数达到fall_count,服务器就被认为是down。

rise(rise_count): 如果连续成功次数达到rise_count,服务器就被认为是up。

timeout: 后端健康请求的超时时间。

default_down: 设定初始时服务器的状态,如果是true,就说明默认是down的,如果是false,就是up的。默认值是true,也就是一开始服务器认为是不可用,要等健康检查包达到一定成功次数以后才会被认为是健康的。

type:健康检查包的类型,现在支持以下多种类型

tcp:简单的tcp连接,如果连接成功,就说明后端正常。

ssl_hello:发送一个初始的SSL hello包并接受服务器的SSL hello包。

http:发送HTTP请求,通过后端的回复包的状态来判断后端是否存活。

mysql: 向mysql服务器连接,通过接收服务器的greeting包来判断后端是否存活。

ajp:向后端发送AJP协议的Cping包,通过接收Cpong包来判断后端是否存活。

port: 指定后端服务器的检查端口。你可以指定不同于真实服务的后端服务器的端口,比如后端提供的是443端口的应用,你可以去检查80端口的状态来判断后端健康状况。默认是0,表示跟后端server提供真实服务的端口一样。该选项出现于Tengine-1.4.0。

官方的解释非常荆楚了.

有个例子可以抄,就是

|

|

加了check以后服务器3秒一次的在check,有error的话会写在error log里面.

|

|

非常的爽.tengine的健康检查模块没有nginx的那种问题.

其实阿里云的slb就是用tengine + lvs来做的,里面的健康检查配置是和tengine一模一样的.如图: